가장 쉽게 이해하는 베이즈 정리(Bayes' Law)

조건부 확률(Conditional Probability)¶

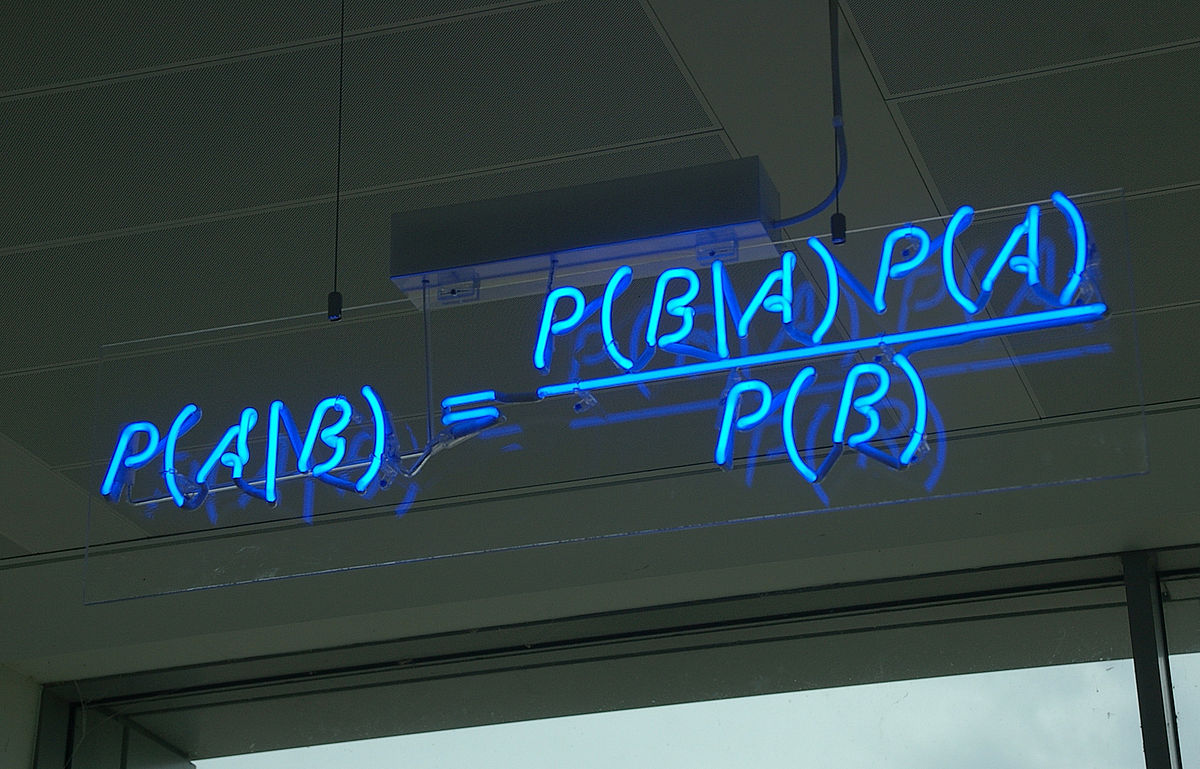

사건 $B$가 발생했을 때 사건 $A$가 발생할 확률은 사건 $B$의 영향을 받아 변하게 될 수도 있습니다. 조건부 확률은 어떤 사건 $B$가 일어났을 때(여기서 $P(B) > 0$ 으로 가정합니다) 사건 $A$가 일어날 확률을 의미합니다. 수식으로는 다음과 같이 정의 됩니다.

$$P(A\,|\,B) = \frac{P(A\cap B)}{P(B)}$$

비슷한 원리로 만약 $P(A) > 0$ 이라면 사건 $A$가 발생했을 때 사건 $B$가 발생할 확률은 다음과 같이 나타낼 수 있습니다.

$$P(B\,|\,A) = \frac{P(A\cap B)}{P(A)}$$

위의 두 식에 간단한 곱셈을 적용하여 우리는 아래의 식을 유추해 낼 수 있습니다. 단순해 보이고 별 의미 없어 보일 수 있지만 앞으로 매우 중요하게 쓰일 식이기 때문에 잘 알아두시면 좋습니다.

$$P(A\cap B)=P(A\,|\,B)P(B) = P(B\,|\,A)P(A)$$

독립사건(Independence)¶

고등학교 수학시간에 두 사건이 서로 독립이라면 다음 식이 성립해야 한다고 배웠습니다.

$$P(A\cap B)=P(A)P(B)$$

이를 사건이 $n$개가 있는 경우로 확장시키면 다음과 같이 나타낼 수 있습니다. 어떠한 $1\leq i_1 < \cdots < i_k \leq n$ 에 대해서도 다음 식을 만족시킨다면 사건 $A_1, \cdots, A_n$ 를 독립인 사건이라고 합니다.

$$P\{A_{i_1}\cap \cdots \cap A_{i_k}\}=P\{A_{i_1}\} \cdots P\{A_{i_k}\}$$

정의가 어렵게 느껴질 수 있어서 보충설명을 드리겠습니다. $i_1,\cdots,i_k$ 라는 숫자는 1에서 $n$까지의 숫자중 임의의 $k$개($n$개 이하)를 뽑은 인덱스 입니다. 즉 $n$개의 사건 중 아무거나 $k$개뽑아서 교집합 한 확률이 각각 확률의 곱과 같다면 독립이라고 할 수 있습니다.

베이즈 정리(Bayes’ Law)¶

베이즈 정리를 정확히 배우기 전에 먼저 분할(Partition) 이라는 개념을 공부해야 합니다. $K$개의 집합 $B_1,\cdots,B_K$가 어떤 집합 $S$의 분할이 되려면 두 조건을 만족해야 합니다.

- 첫번째로 $B_1,\cdots,B_K$ 는 각각 서로소여야 합니다. 집합이 서로소 라는 것은 무작위로 두개를 뽑았을 때 겹치는 부분이 없어야 한다는 뜻입니다.

- 두번째로 $K$개의 $B_1,\cdots,B_K$ 를 합집합 하였을때 그 집합은 정확히 $S$가 되어야 합니다. 이 두 조건을 만족해야 $B_1,\cdots,B_K$ 를 $S$의 분할이라고 할 수 있습니다.

아래 그림에 좋은 예시를 첨부하여 놓았습니다. 집합 $A_1,A_2,A_3,A_4$ 는 각각 서로 겹치는 부분이 없고 합집합을 했을 때 $A$가 되므로 이들은 $A$의 분할이라고 할 수 있습니다.

자 이제 $K$개의 집합 $B_1,\cdots,B_K$가 어떤 사건 $S$의 분할이라고 합시다. 그러면 모든 $S$의 부분집합 $A$에 대해서 다음과 같은 식이 성립하게 됩니다.

$$A= (A \cap B_1) \cup \cdots \cup (A \cap B_K)$$

괄호안의 사건들이 각각 서로소이기 때문에 사건 $A$가 일어날 확률은 아래의 식과 같이 계산 할 수 있습니다.

$$P(A)= P(A \cap B_1) + \cdots + P(A \cap B_K)$$

따라서 어떤 $A$라는 사건이 일어났을때 $B_j$ 라는 사건이 일어날 조건부 확률은 다음과 같이 계산 할 수 있습니다.

$$P(B_j|A)=\frac{P(A|B_j)P(B_j)}{P(A)}=\frac{P(A|B_j)P(B_j)}{P(A|B_1)P(B_1)+\cdots+P(A|B_K)P(B_K)}$$

위의 식을 일반적으로 베이즈 정리라고 합니다. 단순한 수식장난으로 보일 수 있지만 통계학에서는 매우 중요한 의미를 가지고 있는 식이며 베이지안 통계학(Bayesian Statistics)라는 응용 통계학의 분야도 따로 있습니다. 또 머신러닝등 다양한 다른분야에서도 활발하게 활용되고 있습니다.

위 식에서 핵심은 사건 $A$가 일어났을 때의 확률( $P(B_j|A)$ ) 을 계산함에 있어서 이를 거꾸로 뒤집어 $B$가 일어났을때의 확률들( $P(A|B_i)$들 )로 표현 할 수 있다는 것 입니다. 즉 $A$가 조건으로 주어졌을 때 $B$의 확률에 대해서 궁금했던 것을 반대로 $B$가 조건으로 주어졌을 때 $A$의 확률에 대해서 이야기 하는 것으로 바꾸어 쓸 수 있다는 것 입니다. 예제를 통해 적용되는 방식을 살펴보도록 하겠습니다.

어떤 주식이 그날 상승할 확률을 $\theta$라고 합시다. 우리는 일별 주가 데이터 분석을 통해 $\theta$값이 0.4일 확률이 50%이고 0.6일 확률이 50%임을 발견하였습니다. 이를 식으로 표현하면 다음과 같습니다.

$$P(\theta=0.4)=0.5 \,\text{ and }\, P(\theta=0.6)=0.5$$

자 이제 또다른 데이터 관측을 통해 $\theta$값이 결정된 이후 주가가 3일연속 상승할 확률이 $\theta^3$ 으로 주어짐을 알아냈습니다(여기서 서로 다른 날의 주가의 상승과 하락은 독립적이라고 가정하겠습니다). 그렇다면 주가가 3일연속 상승하였을 때, $\theta$값이 0.6인 확률은 얼마나 될까요?

문제를 쉽게 풀기 위해 주가가 3일연속 오른 사건을 A라고 하도록 하겠습니다. 그러면 우리가 구해야 되는 확률은 $P(\theta=0.6\,|\,A)$ 가 되고 이를 베이즈 정리를 통해 나타내면 그 값을 다음과 같이 계산 할 수 있습니다.

$$P(\theta=0.6\,|\,A) = \frac{P(A\,|\,\theta=0.6)P(\theta=0.6)}{P(A\,|\,\theta=0.6)P(\theta=0.6)+P(A\,|\,\theta=0.4)P(\theta=0.4)}$$

$$=\frac{(0.6)^3(0.5)}{(0.6)^3(0.5)+(0.4)^3(0.5)}=0.7714$$

현재 가지고 있는 정보를 기초로하여 정한 초기확률 또는 확률 시행 전에 이미 가지고 있는 지식을 통해 부여한 확률을 사전확률(prior probability) 이라고 합니다. 위의 문제에서는 $\theta$값이 0.4일 확률이 50%이고 0.6일 확률이 50% 라는 사실이 사전확률에 해당됩니다.

사건 발생 후에 어떤 원인으로부터 일어난 것이라고 생각되어지는 확률 또는 추가된 정보로부터 사전정보를 새롭게 수정한 확률을 사후확률(posterior probability) 라고 합니다. 사후확률은 위의 문제에서와 같이 조건부 확률을 통해 표현 할 수 있습니다. 베이즈 정리를 통해 구한 0.7714 라는 수치가 이 문제에서 사후확률에 해당합니다.

이처럼 베이즈 정리는 새로운 정보에 대해 어떻게 대응하여 결과를 도출 해낼지를 알려주는 강력한 도구가 되기 때문에 매우 중요합니다. 일반적으로 우리는 새로운 정보를 너무 무시하거나 과대평가하는 경향성을 가지고 있습니다. 그렇기 때문에 추가적인 정보를 받아들이고 올바른 방향으로 믿음을 수정하는 일은 생각보다 우리에게 매우 힘든 일입니다. 베이즈 정리는 이런 방향성에 대한 수학적인 가이드라인을 제공해 준다는 측면에서 그 중요성을 발견 할 수 있습니다.